Vous publiez du contenu mais certaines pages peinent à apparaître dans Google ? Le problème ne vient pas toujours de vos mots-clés ou de vos backlinks, mais souvent de la façon dont votre site est exploré par les robots. Le crawl et le crawl budget déterminent quelles pages seront découvertes, puis indexées. Autrement dit : sans un crawl efficace, même le meilleur contenu peut rester invisible.

Comprendre le fonctionnement du crawl et du budget de crawl

Avant d’optimiser la structure d’un site, il est essentiel de comprendre comment Google explore réellement les pages. Le crawl correspond à l’activité des robots qui parcourent un site via ses liens et son arborescence. Le crawl budget, lui, désigne la quantité de ressources que Googlebot accepte de consacrer à cette exploration.

Selon Google for Developers, ce budget repose sur deux facteurs clés :

- Le crawl capacity limit : il dépend des performances techniques du serveur. Si celui-ci répond lentement ou génère trop d’erreurs, Googlebot limitera ses passages.

- Le crawl demand : il reflète l’intérêt que Google porte aux pages. Plus elles sont populaires ou mises à jour fréquemment, plus elles seront crawlées.

La vitesse de chargement pèse lourdement dans l’équation. Une étude de Conductor montre qu’un site deux fois plus rapide a vu le nombre d’URLs explorées passer de 150 000 à 600 000 par jour. Autrement dit, optimiser les performances techniques permet de multiplier la capacité d’exploration sans effort supplémentaire sur le contenu.

Mais ce budget est loin d’être toujours utilisé efficacement. Selon Ahrefs et DeepCrawl, près de 50% du crawl budget est gaspillé sur des pages à faible valeur : variantes d’URL, contenus dupliqués, ou encore pages de filtres en e-commerce. Résultat : les pages stratégiques ne bénéficient pas d’un passage régulier de Googlebot.

Cet enjeu touche surtout les sites moyens à grands (dès 10 000 pages) ou ceux qui publient fréquemment du nouveau contenu, comme les sites médias ou e-commerce. Pour un petit site vitrine, l’impact est limité, mais dès que le volume de pages augmente, la gestion du crawl devient un levier SEO incontournable.

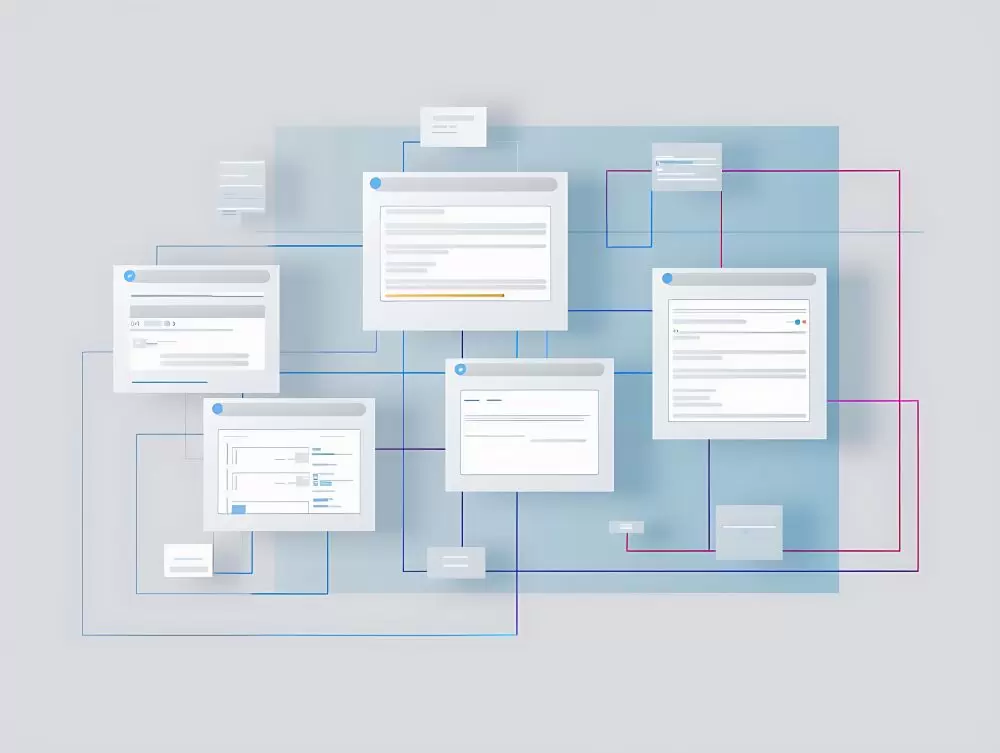

Concevoir une architecture de site claire et accessible

Une structure de site bien pensée est l’un des leviers les plus efficaces pour aider les robots à explorer les pages importantes. Plus un contenu est enfoui dans l’arborescence, plus il sera difficilement accessible à Googlebot.

Profondeur de crawl

Les pages situées à plus de 4 clics depuis la page d’accueil sont perçues comme moins prioritaires et risquent d’être crawlées beaucoup plus rarement, voire de ne jamais être indexées. Au-delà de ce seuil, le budget de crawl se concentre surtout sur les sections accessibles rapidement.

Structure bien organisée = crawl efficace

À l’inverse, une hiérarchie claire comme « page d’accueil > catégories > sous-catégories > fiches » permet d’indiquer sans ambiguïté quelles pages méritent l’attention des robots. Une bonne organisation favorise à la fois la découverte des nouvelles pages et l’indexation régulière de celles déjà publiées.

GDA vous accompagne pour concevoir une architecture claire et performante, afin de faciliter l’exploration des pages par Google et renforcer la visibilité de vos contenus stratégiques.

Optimiser le maillage interne pour guider les robots

Le maillage interne est l’un des leviers les plus puissants pour indiquer aux moteurs de recherche quelles pages d’un site sont prioritaires. Chaque lien interne transmet une part de link equity, une forme de valeur SEO, qui oriente Googlebot vers les contenus stratégiques.

Un maillage interne bien construit permet de hiérarchiser efficacement les pages : les contenus clés (produits phares, pages de services, guides de fond) doivent recevoir davantage de liens internes que des pages secondaires.

À l’inverse, des pages isolées ou insuffisamment reliées risquent de ne jamais être découvertes par les robots, même si elles figurent dans un sitemap. On parle alors de pages orphelines, un signal négatif pour l’indexation.

Utilisez un crawler comme Screaming Frog pour identifier les pages orphelines et redistribuer l’équité interne. Reliez-les à des contenus connexes via des ancres optimisées afin d’améliorer leur visibilité et leur importance aux yeux de Google.

Gérer les ressources bloquantes et éviter le contenu dupliqué

Un site peut perdre une part importante de son budget de crawl si les robots sont contraints d’explorer des contenus inutiles ou dupliqués. La gestion des directives d’exploration est donc essentielle pour orienter Googlebot vers les bonnes pages.

Le fichier Robots.txt

Le fichier robots.txt sert à interdire l’exploration de certaines sections du site (par exemple, les pages d’administration ou les résultats de recherche internes). Cette méthode permet d’éviter que Google consacre du temps de crawl à des ressources inutiles. En revanche, cela ne signifie pas que le budget économisé sera automatiquement redistribué aux autres pages : il restera simplement inutilisé si le serveur n’est pas en mesure de répondre plus vite ou si la demande de crawl est faible.

Pour vérifier les règles d’exploration appliquées à un site, il suffit d’accéder à son fichier robots.txt en ajoutant « /robots.txt » après le nom de domaine (ex. : www.exemple.com/robots.txt). Cela permet de voir en un instant quelles sections du site sont bloquées aux moteurs de recherche.

La balise meta robots

La balise meta robots « noindex » fonctionne différemment. Elle n’empêche pas Googlebot de crawler une page, mais lui indique de ne pas l’indexer. À long terme, cette directive peut inciter Google à réduire l’exploration de ces pages et à concentrer davantage son budget sur les contenus de valeur.

La balise canonical

La balise canonical permet d’indiquer à Google quelle version d’une page doit être considérée comme la principale lorsqu’il existe plusieurs variantes. Contrairement au noindex, elle ne bloque pas l’indexation mais consolide les signaux SEO (backlinks, pertinence, autorité) vers une seule URL.

Sur un site e-commerce, une même fiche produit peut exister en plusieurs versions (tri, couleur, taille, paramètres d’URL). Le canonical permet de renvoyer toutes ces déclinaisons vers l’URL canonique de référence, évitant ainsi un gaspillage de budget sur des doublons.

Faciliter l’exploration avec les bons outils techniques

Même avec une structure optimisée et un maillage interne efficace, il reste indispensable de fournir aux moteurs de recherche des signaux techniques clairs pour orienter leur exploration. Deux leviers sont particulièrement efficaces : les sitemaps et l’analyse de logs.

Orienter le crawl avec des sitemaps bien configurés

Le sitemap XML est l’outil de référence pour guider Google dans la découverte des pages d’un site. Un sitemap complet et à jour permet d’accélérer la prise en compte de nouvelles pages, surtout sur les sites volumineux.

Contrairement au fichier robots.txt, qui se trouve toujours à l’adresse www.exemple.com/robots.txt, l’URL du sitemap varie selon le CMS utilisé (/sitemap.xml, /sitemap_index.xml, etc.). Pour être sûr qu’il soit trouvé facilement par les moteurs, il est recommandé :

- De l’indiquer dans le fichier robots.txt à l’aide de la directive Sitemap: https://www.exemple.com/sitemap.xml.

- Et de le soumettre directement dans Google Search Console, ce qui garantit sa prise en compte rapide.

De plus, mettre régulièrement à jour son sitemap augmente significativement la probabilité qu’une URL soit crawlée rapidement. Les pages stratégiques (nouveaux produits, actualités, contenus prioritaires) doivent donc toujours y figurer en priorité.

Facilitez le travail de Google en créant un sitemap par type de contenu : un pour les articles de blog, un pour les produits, un pour les catégories, un pour les pages institutionnelles, etc.

Cela permet :

- D’organiser vos URLs de manière claire,

- De ne pas dépasser la limite de 50 000 URLs par sitemap,

- Et de suivre plus facilement l’indexation de chaque section dans Google Search Console.

Mise en place : générez plusieurs fichiers XML (/sitemap-articles.xml, /sitemap-produits.xml, /sitemap-categories.xml…), regroupez-les dans un sitemap_index.xml, puis déclarez ce fichier index dans votre robots.txt et dans Search Console.

Vérifier l’efficacité réelle avec l’analyse des logs serveur

Les logs serveur donnent un aperçu concret du comportement des robots. En se basant sur une étude Botify, on constate que seulement 40% des URLs stratégiques sont crawlées chaque mois, ce qui laisse 60% de contenu potentiellement sous-exploité ; un véritable gisement d’opportunités perdu.

Adapter sa stratégie selon le type de site

Les bonnes pratiques de crawl ne sont pas les mêmes selon la taille et la nature du site. Les besoins d’un petit site vitrine diffèrent fortement de ceux d’un e-commerce ou d’un média.

Petit site (moins de 10 000 pages)

Pour les sites de taille modeste, la gestion du crawl reste relativement simple. Un sitemap XML bien configuré associé à un maillage interne logique suffit généralement à garantir une exploration complète. Dans ce cas, l’enjeu n’est pas de limiter le gaspillage du budget de crawl, mais de s’assurer que Google explore correctement les pages stratégiques (services, formulaire de contact, contenus à forte valeur).

Grands sites, e-commerce et médias

Les sites volumineux présentent des défis plus complexes. Le gaspillage du crawl budget y est souvent élevé, notamment à cause :

- Des filtres et facettes en e-commerce (ex. : tri par prix, couleur, taille),

- Des chaînes de redirections,

- Des pages produits similaires ou peu différenciées.

Les sites médias, quant à eux, doivent gérer une autre contrainte : la fraîcheur du contenu. Plus un site publie souvent, plus Google lui consacrera de ressources d’exploration. C’est ce qui permet aux articles d’actualité d’être indexés parfois en quelques minutes seulement.

Google consacre davantage de ressources de crawl aux sites qui publient du contenu frais de manière régulière, comme les médias en ligne. À l’inverse, un site peu mis à jour verra son budget de crawl se concentrer sur des vérifications ponctuelles plutôt que sur une exploration intensive.

Suivre et ajuster le crawl en continu

Optimiser la structure d’un site pour le crawl ne suffit pas : il faut aussi mesurer régulièrement l’efficacité des actions mises en place. Les outils proposés par Google et l’analyse technique permettent d’identifier les points de blocage et d’ajuster la stratégie.

Google Search Console : crawl stats

Le rapport Crawl Stats de Google Search Console donne une vision précise du volume de pages explorées par Googlebot chaque jour. Certaines optimisations (vitesse, hiérarchie, maillage) peuvent multiplier la fréquence d’exploration.

Exemple concret : un site est passé de 27 pages crawlées par jour (environ 810/mois) à 253 pages par jour après amélioration de ses performances techniques et de son architecture.

Surveiller la santé du crawl (crawl health)

La capacité d’exploration est directement liée à la santé technique du site. Moins il y a d’erreurs serveur (codes 5xx) et plus les temps de réponse sont rapides (<300 ms), plus Google sera en mesure de crawler efficacement. Ces deux indicateurs doivent être suivis en continu.

Stratégie ciblée vs globale

Il est tentant de chercher à augmenter globalement le crawl rate, mais cette approche est rarement efficace. L’inspection d’URL dans Search Console reste un outil plus pertinent : il permet de demander l’exploration rapide de pages précises (nouveaux produits, contenus mis à jour, pages stratégiques), plutôt que de diluer le budget sur l’ensemble du site.

Analysez vos logs serveur chaque mois. C’est le seul moyen de savoir si Google consacre son budget de crawl à vos pages stratégiques ou s’il le gaspille sur des contenus secondaires (filtres, doublons, pages techniques).